Clusters InfiniBand à Petite Échelle - Solutions Multimodes

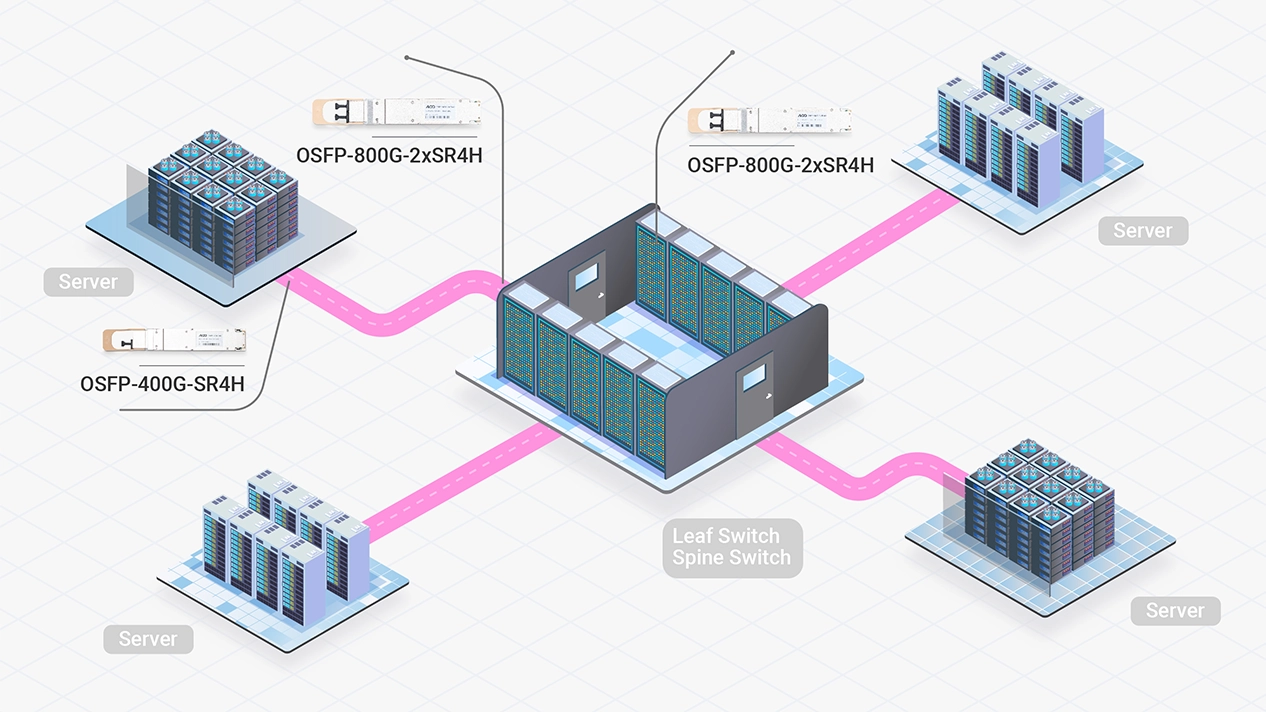

Les modules multimodes offrent des performances fiables et économiques sur de courtes distances.

Le routage adaptatif, le calcul en réseau et l'architecture de contrôle de congestion permettent à InfiniBand de répondre aux exigences rigoureuses des clusters HPC et IA. Ces optimisations garantissent un flux de données transparent, éliminent les goulots d'étranglement et permettent une utilisation efficace des ressources, ce qui se traduit par des performances supérieures et une efficacité opérationnelle accrue pour les infrastructures complexes.

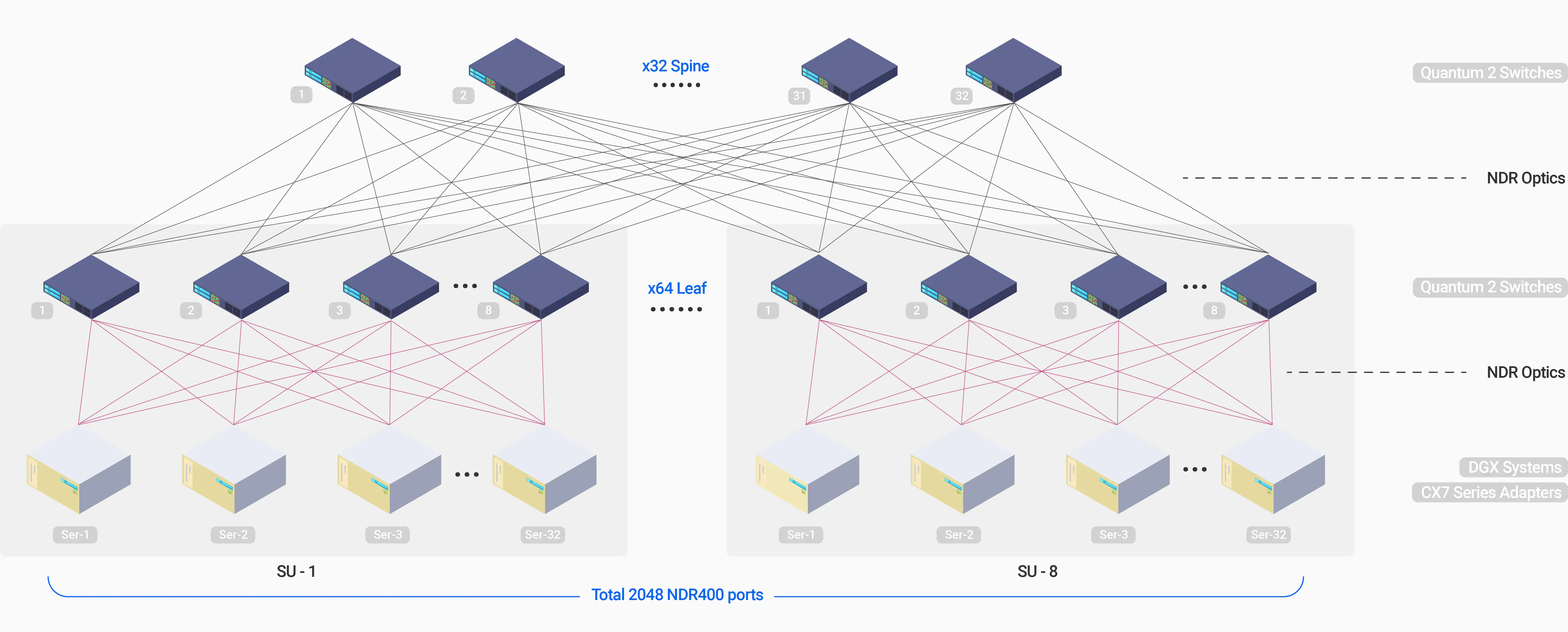

La topologie Fat-Tree est largement reconnue comme une architecture optimale pour les clusters de GPU d'IA basés sur InfiniBand, garantissant une bande passante constante et un débit élevé pour les déploiements à grande échelle. En exploitant du matériel de pointe comme les GPU NVIDIA H100 et H200, la plateforme DGX et des solutions émergentes telles que GB200, cette topologie est particulièrement adaptée à la gestion des charges de travail intensives d'IA. Par exemple, avec les switches Quantum-2 et les adaptateurs/NICs ConnectX-7 offrant 8 ports simples 400G par nœud, une configuration Fat-Tree à 3 niveaux peut évoluer pour prendre en charge jusqu'à 65 000 GPU, tandis qu'une configuration à 2 niveaux, plus courante, gère efficacement les clusters jusqu'à 2 000 GPU.

Solutions flexibles adaptées aux différentes tailles de clusters d'IA, aux agencements des centres de données et aux distances de connexion.

Les modules multimodes offrent des performances fiables et économiques sur de courtes distances.

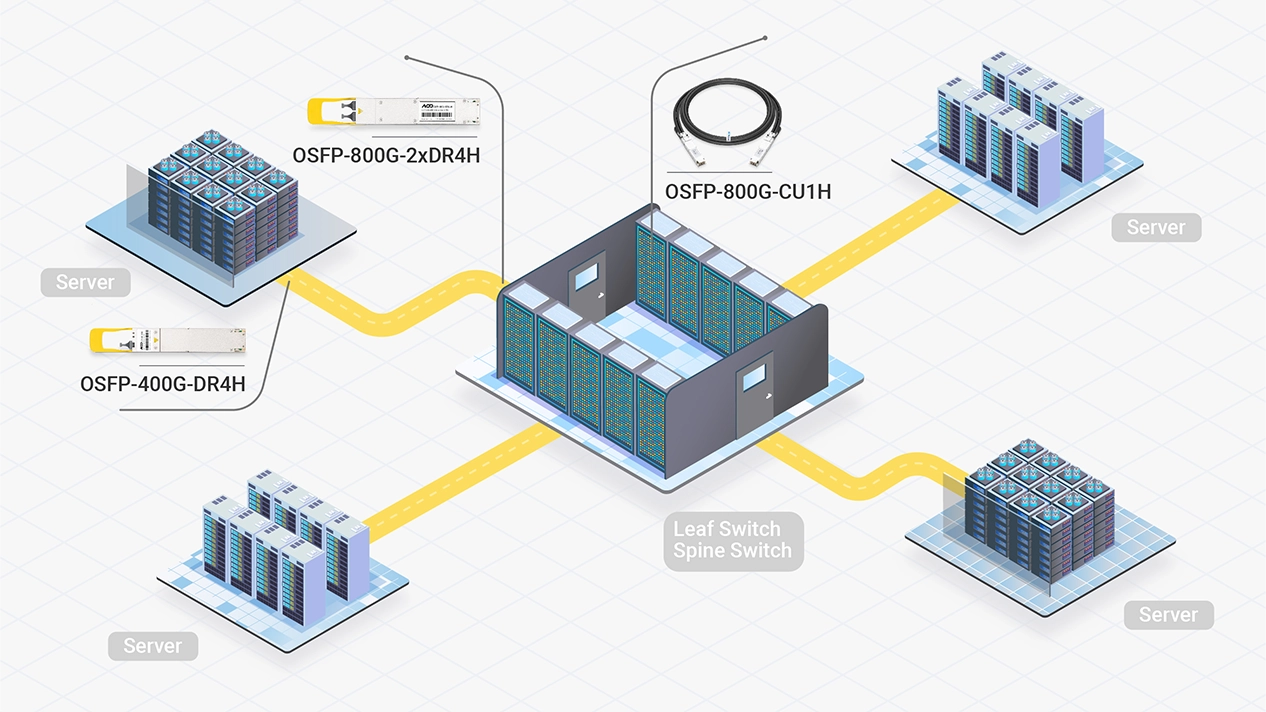

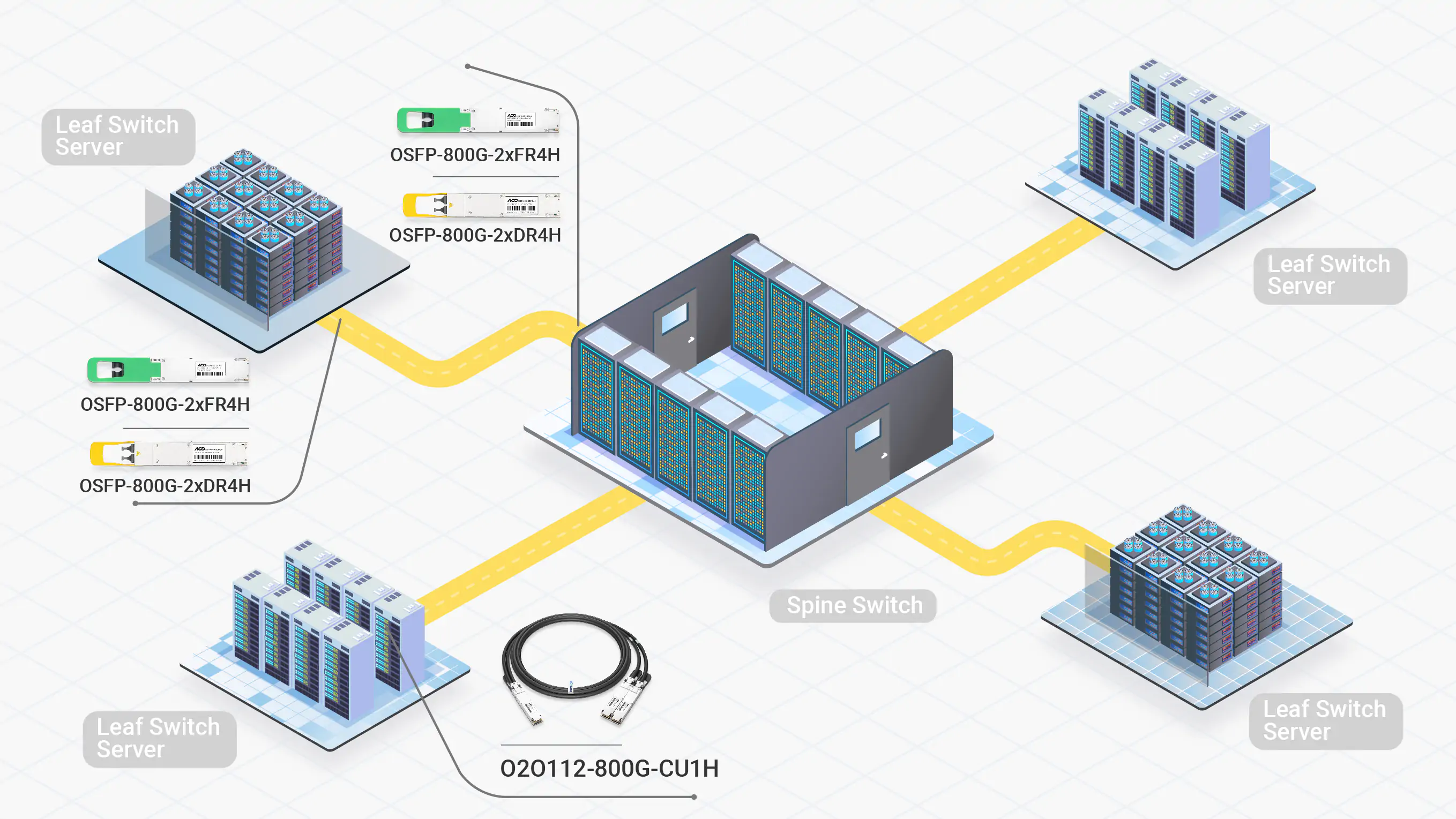

Les module optiques monomodes permettent des connexions stables sur de longues distances, tandis que les câbles DAC réduisent les coûts et la consommation d'énergie. Ensemble, ils constituent une solution efficace pour les clusters de taille moyenne à grande. Les câbles DAC nécessite une planification minutieuse de l'agencement en raison de leurs distances plus courtes et du câblage plus épais.

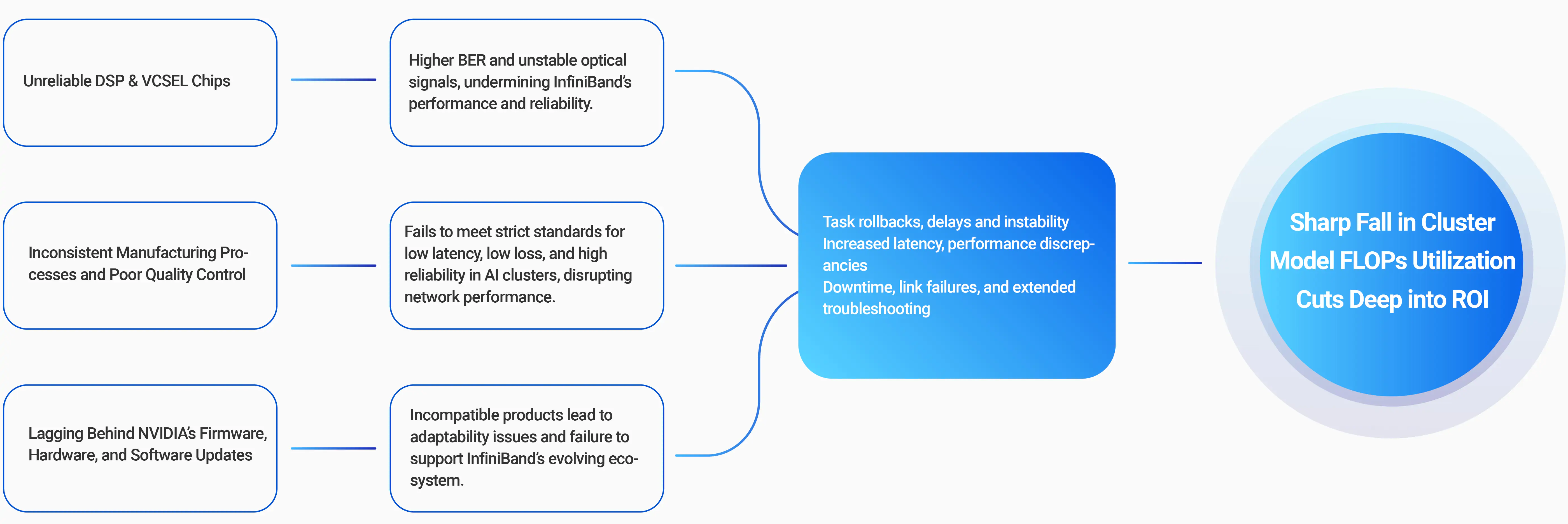

80 % des Interruptions de Formation à l'IA proviennent de Problèmes de Réseau.

95 % des Problèmes Réseau sont souvent Liés à des Interconnexions Optiques Défectueuses

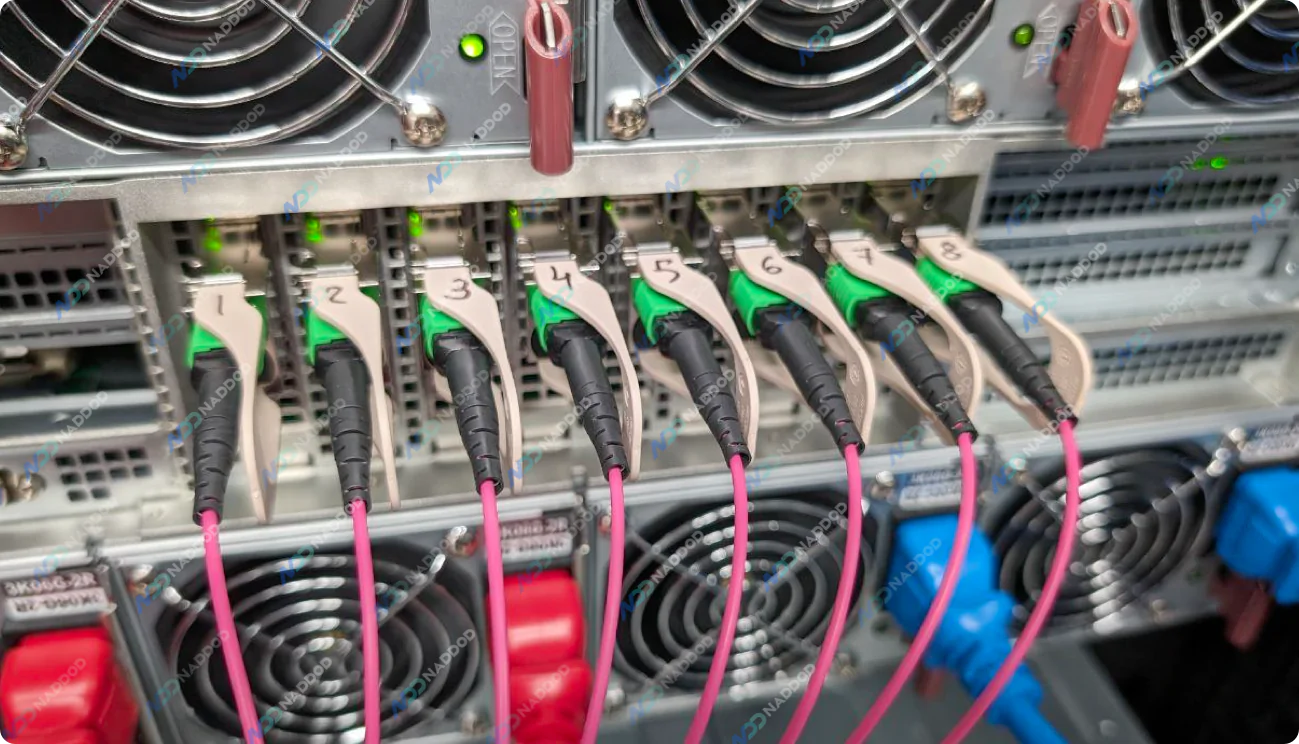

Les options de connectivité NVIDIA Quantum-2 permettent des topologies flexibles avec une grande variété d'émetteurs-récepteurs, de connecteurs MPO, de câbles ACC, DAC avec différents types de séparateurs 1-2 ou 1-4. La rétrocompatibilité permet de connecter des clusters de 400 Gb/s aux infrastructures existantes de 200 Gb/s ou 100 Gb/s, assurant une évolutivité et une intégration transparentes.

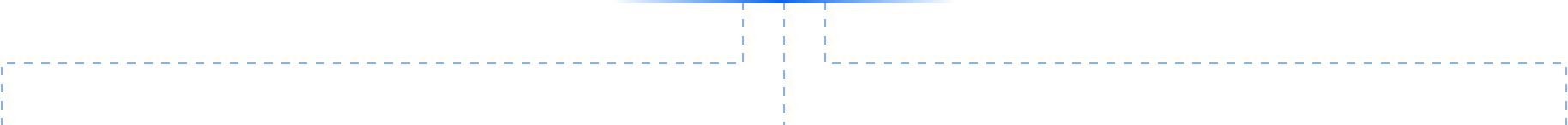

Optiques InfiniBand NDRL'adaptateur InfiniBand NVIDIA ConnectX-7 offre des performances inégalées pour les charges de travail d'IA et de HPC. Prenant en charge PCIe Gen4 et Gen5, il propose des ports réseau simples ou doubles avec des vitesses allant jusqu'à 400 Gb/s, disponibles dans plusieurs facteurs de forme pour répondre à divers besoins de déploiement.

Les capacités avancées d'informatique en réseau (In-Network Computing) et les moteurs programmables intégrés au ConnectX-7 permettent un prétraitement efficace des algorithmes de données et le déchargement des chemins de contrôle des applications directement sur le réseau. Ces fonctionnalités optimisent les performances, réduisent la latence et améliorent l'évolutivité des applications exigeantes.

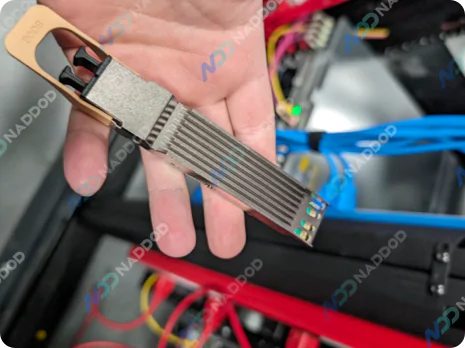

Adaptateur ConnectX-7Les switches NVIDIA Quantum-2 prennent en charge jusqu'à 64 ports de 400 Gb/s ou 128 ports de 200 Gb/s en utilisant 32 connecteurs OSFP. Le format compact 1U est disponible avec des options de refroidissement par air ou par liquide, offrant une flexibilité pour une gestion interne ou externe.

Offrant un débit bidirectionnel agrégé de 51,2 Tbit/s et traitant plus de 66,5 milliards de paquets par seconde (pps), les switches Quantum-2 répondent aux exigences des réseaux haute performance d'IA et HPC.

Switches Quantum-2

Associez-vous à NADDOD pour Accélérer Votre Réseau InfiniBand et Propulser l'Innovation en IA de Nouvelle Génération